Perbezaan antara orc dan parket

- 4749

- 506

- Gilbert Schumm

Kedua-dua Orc dan Parquet adalah format penyimpanan fail kolumnar sumber terbuka yang popular di ekosistem Hadoop dan mereka agak serupa dari segi kecekapan dan kelajuan, dan di atas semua, mereka direka untuk mempercepat beban kerja analisis data besar. Bekerja dengan fail ORC adalah semudah bekerja dengan fail parket kerana mereka menawarkan keupayaan membaca dan menulis yang efisien ke atas rakan-rakan mereka yang berasaskan baris. Kedua -duanya mempunyai bahagian yang saksama dari kebaikan dan keburukan, dan sukar untuk mengetahui yang lebih baik daripada yang lain. Mari kita lihat lebih baik masing -masing. Kami akan bermula dengan Orc terlebih dahulu, kemudian berpindah ke Parqu.

Orc

ORC, pendek untuk kolumnar baris yang dioptimumkan, adalah format penyimpanan kolumnar percuma dan sumber terbuka yang direka untuk beban kerja Hadoop. Seperti namanya, ORC adalah format fail yang dioptimumkan sendiri, yang menyimpan data dalam lajur yang membolehkan pengguna membaca dan menyegarkan hanya kepingan yang mereka perlukan. Ini adalah pengganti format Fail Rekod Rekod Tradisional (RCFile) yang direka untuk mengatasi batasan format fail sarang lain. Ia mengambil masa yang lebih sedikit untuk mengakses data dan juga mengurangkan saiz data sehingga 75 peratus. ORC menyediakan cara yang lebih cekap dan lebih baik untuk menyimpan data untuk diakses melalui penyelesaian SQL-on-Hadoop seperti Hive menggunakan Tez. ORC memberikan banyak kelebihan ke atas format fail sarang lain seperti pemampatan data yang tinggi, prestasi yang lebih cepat, ciri menolak ramalan, dan lebih banyak lagi, data yang disimpan dianjurkan menjadi jalur, yang membolehkan bacaan besar dan cekap dari HDFS.

Parket

Parquet adalah satu lagi format fail berorientasikan lajur sumber terbuka dalam ekosistem Hadoop yang disokong oleh Cloudera, dengan kerjasama Twitter. Parket sangat popular di kalangan pengamal data besar kerana ia memberikan banyak pengoptimuman penyimpanan, terutamanya dalam beban kerja analisis. Suka ORC, Parquet Menyediakan Mampan Kolumnar Menjimatkan banyak ruang penyimpanan sambil membolehkan anda membaca lajur individu dan bukannya membaca fail lengkap. Ia memberikan kelebihan yang ketara dalam keperluan prestasi dan penyimpanan berkenaan dengan penyelesaian penyimpanan tradisional. Lebih berkesan dalam melakukan operasi gaya io data dan sangat fleksibel ketika menyokong struktur data bersarang yang kompleks. Sebenarnya, ia direka khas untuk menjaga struktur data bersarang. Parquet juga merupakan format fail yang lebih baik dalam mengurangkan kos storan dan mempercepatkan langkah bacaan ketika datang ke set besar data. Parquet berfungsi dengan baik dengan Apache Spark. Malah, ia adalah format fail lalai untuk menulis dan membaca data dalam Spark.

Perbezaan antara orc dan parket

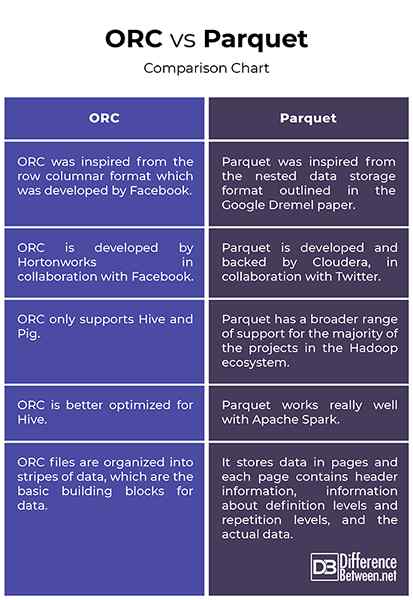

Asal

- ORC diilhamkan dari format kolumnar baris yang dibangunkan oleh Facebook untuk menyokong bacaan kolumnar, pushdown ramalan dan malas membaca. Ia adalah pengganti format Fail Rekod Rekod Tradisional (RCFile) dan menyediakan cara yang lebih berkesan untuk menyimpan data relasi daripada RCFile, mengurangkan saiz data sehingga 75 peratus. Parquet, sebaliknya, diilhamkan dari format penyimpanan data bersarang yang digariskan dalam kertas Google Dremel dan dibangunkan oleh Cloudera, dengan kerjasama Twitter. Parquet kini menjadi projek inkubator Apache.

Sokongan

- Kedua-dua ORC dan Parquet adalah format fail data besar yang berorientasikan lajur yang berkongsi hampir reka bentuk yang sama kerana kedua-dua data saham dalam lajur. Walaupun parket mempunyai pelbagai sokongan yang lebih luas untuk majoriti projek dalam ekosistem Hadoop, ORC hanya menyokong sarang dan babi. Satu perbezaan utama antara keduanya ialah Orc lebih baik dioptimumkan untuk sarang, sedangkan parket berfungsi dengan baik dengan Apache Spark. Malah, Parquet adalah format fail lalai untuk menulis dan membaca data di Apache Spark.

Pengindeksan

- Bekerja dengan fail ORC semudah bekerja dengan fail parket. Kedua-duanya bagus untuk beban kerja yang dibaca. Walau bagaimanapun, fail ORC dianjurkan ke dalam jalur data, yang merupakan blok bangunan asas untuk data dan bebas antara satu sama lain. Setiap jalur mempunyai indeks, data baris dan footer. Footer adalah di mana statistik utama bagi setiap lajur dalam jalur seperti Count, Min, Max, dan Sum Cache. Parquet, sebaliknya, menyimpan data di halaman dan setiap halaman mengandungi maklumat header, maklumat mengenai tahap definisi dan tahap pengulangan, dan data sebenar.

Orc vs. Parket: carta perbandingan

Ringkasan

Kedua-dua ORC dan Parquet adalah dua format penyimpanan fail berorientasikan lajur yang paling popular di ekosistem Hadoop yang direka untuk berfungsi dengan baik dengan beban kerja analisis data. Parquet dibangunkan oleh Cloudera dan Twitter bersama -sama untuk menangani masalah dengan menyimpan set data besar dengan lajur yang tinggi. ORC adalah pengganti spesifikasi rcfile tradisional dan data yang disimpan dalam format fail orc dianjurkan menjadi jalur, yang sangat dioptimumkan untuk operasi membaca HDFS. Parquet, sebaliknya, adalah pilihan yang lebih baik dari segi penyesuaian jika anda menggunakan beberapa alat dalam ekosistem Hadoop. Parket lebih baik dioptimumkan untuk digunakan dengan Apache Spark, sedangkan ORC dioptimumkan untuk sarang. Tetapi untuk sebahagian besar, kedua -duanya agak serupa tanpa perbezaan yang signifikan antara kedua -dua.