Perbezaan antara mapreduce dan percikan api

- 864

- 181

- Gilbert Schumm

Apache Spark adalah salah satu projek sumber terbuka yang paling aktif dalam ekosistem Hadoop dan salah satu teknologi terpanas dalam analisis data besar hari ini. Kedua -dua MapReduce dan Spark adalah kerangka sumber terbuka untuk pemprosesan data besar. Walau bagaimanapun, Spark terkenal dengan pemprosesan dalam memori dan sesuai untuk keadaan di mana data sesuai dengan memori, terutamanya pada kelompok khusus. Kami membandingkan dua rangka kerja perisian terkemuka untuk membantu anda menentukan yang sesuai untuk anda.

Apa itu Hadoop MapReduce?

MapReduce adalah model pengaturcaraan dalam kerangka Hadoop untuk pengkomputeran yang diedarkan berdasarkan Java. Ia digunakan untuk mengakses data besar dalam sistem fail Hadoop (HDFS). Ini adalah cara untuk menstrukturkan pengiraan anda yang membolehkannya mudah dijalankan di banyak mesin. Ia membolehkan skalabiliti besar -besaran di ratusan atau ribuan pelayan dalam kumpulan Hadoop. Ia membolehkan penulisan pekerjaan yang diedarkan, berskala dengan sedikit usaha. Ia berfungsi dua fungsi penting: ia menapis dan mengedarkan kerja ke pelbagai nod dalam kelompok atau peta. Ia digunakan untuk analisis data berskala besar menggunakan pelbagai mesin dalam kelompok. Rangka Kerja MapReduce biasanya merupakan proses tiga langkah: peta, shuffle dan mengurangkan.

Apa itu Apache Spark?

Spark adalah sumber terbuka, rangka kerja data besar yang sangat cepat dianggap sebagai pengganti kepada rangka kerja MapReduce untuk memproses data besar. Spark adalah peningkatan Hadoop untuk MapReduce yang digunakan untuk beban kerja data besar. Untuk organisasi yang mempunyai banyak data untuk dianalisis, Spark menawarkan cara yang cepat dan mudah untuk menganalisis data tersebut di seluruh kumpulan komputer. Ini adalah enjin analisis bersatu pelbagai bahasa untuk data besar dan pembelajaran mesin. Model pengaturcaraan bersatu menjadikannya pilihan terbaik untuk pemaju membina aplikasi analitik yang kaya dengan data. Ia bermula pada tahun 2009 sebagai projek penyelidikan di amplab UC Berkley, usaha kerjasama yang melibatkan pelajar, penyelidik dan fakulti.

Perbezaan antara mapreduce dan percikan api

Pemprosesan data

- Hadoop memproses data dalam kelompok dan MapReduce beroperasi dalam langkah berurutan dengan membaca data dari cluster dan melaksanakan operasinya pada data. Hasilnya kemudian ditulis kembali ke kluster. Ini adalah cara yang berkesan untuk memproses dataset statik yang besar. Spark, sebaliknya, adalah enjin pemprosesan data yang diedarkan secara umum yang memproses data selari merentasi kelompok. Ia melakukan pemprosesan data masa nyata dan grafik data.

Prestasi

- Hadoop MapReduce agak perlahan kerana ia melakukan operasi pada cakera dan ia tidak dapat menyampaikan analisis masa nyata dari data. Spark, sebaliknya, direka sedemikian rupa sehingga ia mengubah data dalam memori dan tidak dalam cakera I/O, yang secara gilirannya mengurangkan masa pemprosesan. Spark sebenarnya 100 kali lebih cepat dalam memori dan 10 kali lebih cepat pada cakera. Tidak seperti MapReduce, ia dapat menangani pemprosesan masa nyata.

Kos

- Hadoop berjalan pada kos yang lebih rendah kerana ia adalah perisian sumber terbuka dan memerlukan lebih banyak memori pada cakera yang agak komoditi murah. Spark memerlukan lebih banyak RAM yang bermaksud menubuhkan kluster percikan boleh lebih mahal. Selain itu, Spark agak baru, jadi pakar dalam percikan adalah penemuan yang jarang berlaku dan lebih mahal.

Toleransi kesalahan

- MapReduce adalah berasaskan cakera yang ketat menggunakan penyimpanan yang berterusan. Walaupun kedua -duanya memberikan beberapa tahap kegagalan pengendalian, toleransi kesalahan Spark didasarkan terutamanya pada operasi RDD (dataset yang diedarkan tahan). RDD adalah blok bangunan Apache Spark. Hadoop secara semulajadi salah toleran kerana ia direka untuk meniru data di beberapa nod.

Kemudahan penggunaan

- MapReduce tidak mempunyai mod interaktif dan agak kompleks. Ia perlu mengendalikan API tahap rendah untuk memproses data, yang memerlukan banyak pengekodan, dan pengekodan memerlukan pengetahuan tentang struktur data yang terlibat. Spark direkayasa dari bawah untuk prestasi dan kemudahan penggunaan, yang berasal dari model pengaturcaraan umumnya. Juga, program selari kelihatan seperti program berurutan, menjadikannya lebih mudah untuk berkembang.

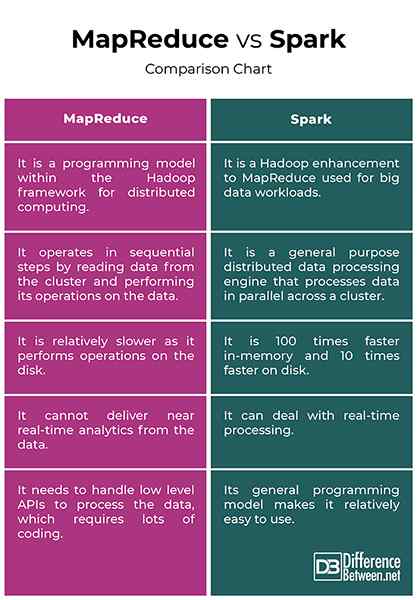

MapReduce vs. Spark: Carta Perbandingan

Ringkasan

Perbezaan utama antara kedua -dua rangka kerja ialah MapReduce memproses data pada cakera manakala proses percikan dan mengekalkan data dalam ingatan untuk langkah -langkah berikutnya. Akibatnya, Spark adalah 100 kali lebih cepat dalam memori dan 10 kali lebih cepat pada cakera daripada MapReduce. Hadoop menggunakan MapReduce untuk memproses data, manakala Spark menggunakan dataset yang diedarkan berdaya tahan (RDD). Spark adalah peningkatan Hadoop MapReduce untuk memproses data besar. Walaupun MapReduce masih digunakan untuk analisis data berskala besar, Spark telah menjadi rangka kerja pemprosesan di persekitaran Hadoop.

Mengapa percikan lebih cepat daripada MapReduce?

Proses Spark dan mengekalkan data dalam ingatan untuk langkah -langkah berikutnya, yang menjadikannya 100 kali lebih cepat untuk data dalam RAM dan sehingga 10 kali lebih cepat untuk data penyimpanan. RDDnya membolehkan beberapa operasi peta dalam ingatan, sementara MapReduce harus menulis hasil interim ke cakera.

Apakah perbezaan antara Spark dan MapReduce nama sekurang -kurangnya dua mata?

Pertama, MapReduce tidak dapat menyampaikan analisis masa nyata dari data, sementara Spark dapat menangani pemprosesan masa nyata data. Dan kedua, MapReduce beroperasi dalam langkah -langkah berurutan manakala Spark memproses data selari merentasi kelompok.

Adalah percikan lebih maju daripada mapreduce?

Spark secara meluas dianggap sebagai pengganti Rangka Kerja MapReduce untuk memproses data besar. Malah, Spark adalah salah satu projek sumber terbuka yang paling aktif dalam ekosistem Hadoop dan salah satu teknologi terpanas dalam analisis data besar hari ini.

Adakah percikan memerlukan MapReduce?

Spark tidak menggunakan atau memerlukan MapReduce, tetapi hanya idea dan bukan pelaksanaan yang tepat.

- « Perbezaan antara kecenderungan pembelajaran mesin dan varians

- Perbezaan antara rig masthead dan pecahan »